Digitale Durchgängigkeit und somit erweiterte Analysemöglichkeiten wirken nachweislich positiv auf das Geschäft. Fertigungsunternehmen, die mit ihren Daten aktiv arbeiten, haben nachweislich Vorteile im Geschäftserfolg, wie etwa die aktuelle Studie „Digitalisierungindex Mittelstand“ zeigt. Auch aktuelle Anforderungen durch Internet of Things und die vernetzte Produktion lassen sich so besser meistern. Verbundene datentechnische Herausforderungen sind durch interdisziplinäre Zusammenarbeitsmodelle wie Data Thinking sowie Hilfsmittel wie Low Code mit vertretbarem Aufwand lösbar.

Unverhofft kommt oft, weiß schon der Volksmund: Ob Lieferketten in der Pandemie aufbrechen, ein Tanker im Suez-Kanal strandet oder ein Produkt plötzlich Schäden zeigt. Jeweils bedarf es eines schnellen Überblicks zu ziemlich vielen Details. Aber auch planmäßig eingeschlagene Geschäftsstrategien verlangen fortlaufend nach Kontrolle und möglicher Optimierung. Voraussetzung ist jeweils die Verfügbarkeit von Daten mit klarer Bedeutung aus vielen Quellen.

Daten als Erfolgsfaktor und Hürde

Doch sind Daten nicht sofort Erfolgsfaktor, sondern zunächst auch Hürde: Denn aktuelle Handlungsfelder wie eine individualisierte Massenfertigung, die laufendes Kundenfeedback in viele Varianten gießen soll, basieren essenziell auf systemübergreifend verfügbaren Daten mit klarer Bedeutung. Auch Anforderungen wie agile, globale Partner-Netzwerke wie auch eine hohe Energie- und Ressourceneffizienz bis hin zur verschwendungsfreien Fertigung benötigen durchgängig Daten entlang des Produktlebenszyklus. Typische Herausforderungen für die ganzheitliche Analyse von Daten entstehen dann u.a. durch die technische Integration von Informationstechnologie (IT), Betriebstechnik (OT) und Entwicklungstechnik (ET), zumal sie Prämissen wie Datensicherheit integrieren soll.

Noch komplexer verhalten sich künftige Fertigungsszenarien wie etwa die sogenannte Kognitive Fertigung mit ihrer Hypervernetzung aller Maschinen, dem KI-gesteuerten Betrieb, der smarten Optimierung von Ressourcen und einem Manufacturing-as-a-Service, bei dem direktes Kundenfeedback, etwa durch Sensorik in Produkten, flexibel und zeitnah Fertigungsprozesse auslöst. Viele dieser durchweg hohen, fachlichen Herausforderungen lassen sich aber mit digitaler Durchgängigkeit und der hiermit möglichen Aggregation von Daten zu Informationen konkret wertschöpfend angehen. Auf einer solchen Basis entstünde auch enormes Potenzial für neue, informationszentrische Geschäftsmodelle, die neue Kundenerlebnisse schaffen, die Produktivität steigern oder Entscheidungsprozesse beschleunigen.

Auch wenn aktuell in vielen Unternehmen die nachhaltige Architektur für eine digitale Durchgängigkeit in Daten und Prozessen – hierzu bedarf es etwa einer Plattformebene, die unternehmensweit Digital Twins, Data Lakes, Analytics und App Stores verbindet – noch fehlt, gibt es Methoden und Werkzeuge, die schnelle Erfolge mit messbarem Erfolg entwickeln können.

Data Thinking als Dreiklang erfolgsbewährter Methoden

Eine typische Ursache für das Scheitern von IIoT-Projekten ist nach wie vor ein fehlendes gegenseitiges Verständnis zwischen dem IT-Bereich, der Daten für Geschäftsmodelle aufbereiten soll, und den Fachbereichen, denen konkrete Vorstellungen von Möglichkeiten und Grenzen für Analytics und Artificial Intelligence fehlen. Da neue Geschäftsmodelle in aller Regel einen Dreiklang aus Innovation, Data Science und Agilität darstellen, ist eine Kombination sinnvoll, um das Beste aus Design Thinking, CRISP-DM (branchenübergreifender Standardprozess für Data Mining) und agilem Entwickeln zu einem Framework zu kombinieren. Dieser, von Detecon entwickelte, Prozess des „Data Thinking“ verbindet den Fokus auf das fachliche Handlungsfeld mit agilen Methoden für das Lösungsdesign und die Umsetzung. Er soll sicherstellen, dass datengesteuerte Projekte mit einer höheren Erfolgsquote abgeschlossen werden können.

Bei Data Thinking stehen nicht mehr die Technik oder die Daten allein im Vordergrund, sondern die gemeinsame Entwicklung von Geschäftsmodellen. Dazu identifiziert ein Projektteam, bestehend aus einem Innovationscoach, den Vertretern der Geschäftsbereiche, aber auch Data Scientists und Data Engineers den Geschäftsbedarf und verschiedene Lösungsansätze. Auf Basis verschiedener Proofs of Concept werden Umsetzungsschwierigkeiten bereits im Lab-Modus erkannt und können vor der Implementierung gegeneinander abgewogen werden. Typische Iterationen beziehen sich in der Regel auf die Optimierung der Datenqualität, den Vergleich von Szenarien und Algorithmen und erweiterte Variablen bei Regressionen, Entscheidungswäldern und Neuronalen Netzen.

Low Code für unternehmenseigenen App Store

Eine technische Herausforderung datengesteuerter Initiativen bleibt weiterhin das semantisch korrekte Zusammenführen von Daten aus unterschiedlichsten internen und externen Quellen sowie deren geschäftsrelevante Verwendung in Analysen und Aktionen. Ein besonders wertvolles und pragmatisches Instrument, um kurzfristigen Informationsbedarf über Betriebsabläufe zu decken, ist Low Code. Diese Entwicklungsplattform ermöglicht es Interessierten, ohne besondere IT-Kenntnisse und unabhängig von komplexen Datenformaten eigene Business-Apps zu bauen.

Wie in einem Lego-Baukasten lassen sich auf grafische Weise Standard-Programmierblöcke zu Funktionsbausteinen zusammensetzen. Realisierbar sind dann beispielsweise Apps, die aus externen Quellen mittels Crowd-Intelligenz die optimalen Einstellungen eines weltweit eingesetzten Maschinentyps orchestrieren. Oder Apps, die auf Basis von Predictive Maintenance die besten Wartungsintervalle errechnen. Auf die Spitze getrieben wird dieses Prinzip auf sogenannten No-Code-Plattformen, wo keinerlei Programmierung verlangt und Aufgaben rein logisch zusammengestellt werden. Wenn der Werksplaner also eine bestimmte Information benötigt, kann er diese mittels Low Code oder No Code selbst erheben, um so den Fabrikbetrieb bestmöglich zu simulieren und zu steuern.

Praxistest im Industrial IoT Center: OEE und Gebäudemanagement

Eine Praxisdemonstration vom Zusammenspiel aus Methoden wie Data Thinking und Programmierumgebungen wie der Low-Code-Plattform zeigt Detecon in seinem Industrial IoT Center in Berlin: Dort wird beispielsweise die Verbesserung einer Gesamtanlageneffektivität (englisch OEE, Overall Equipment Effectiveness) in einem Ecosystem digitaler Zwillinge demonstriert.

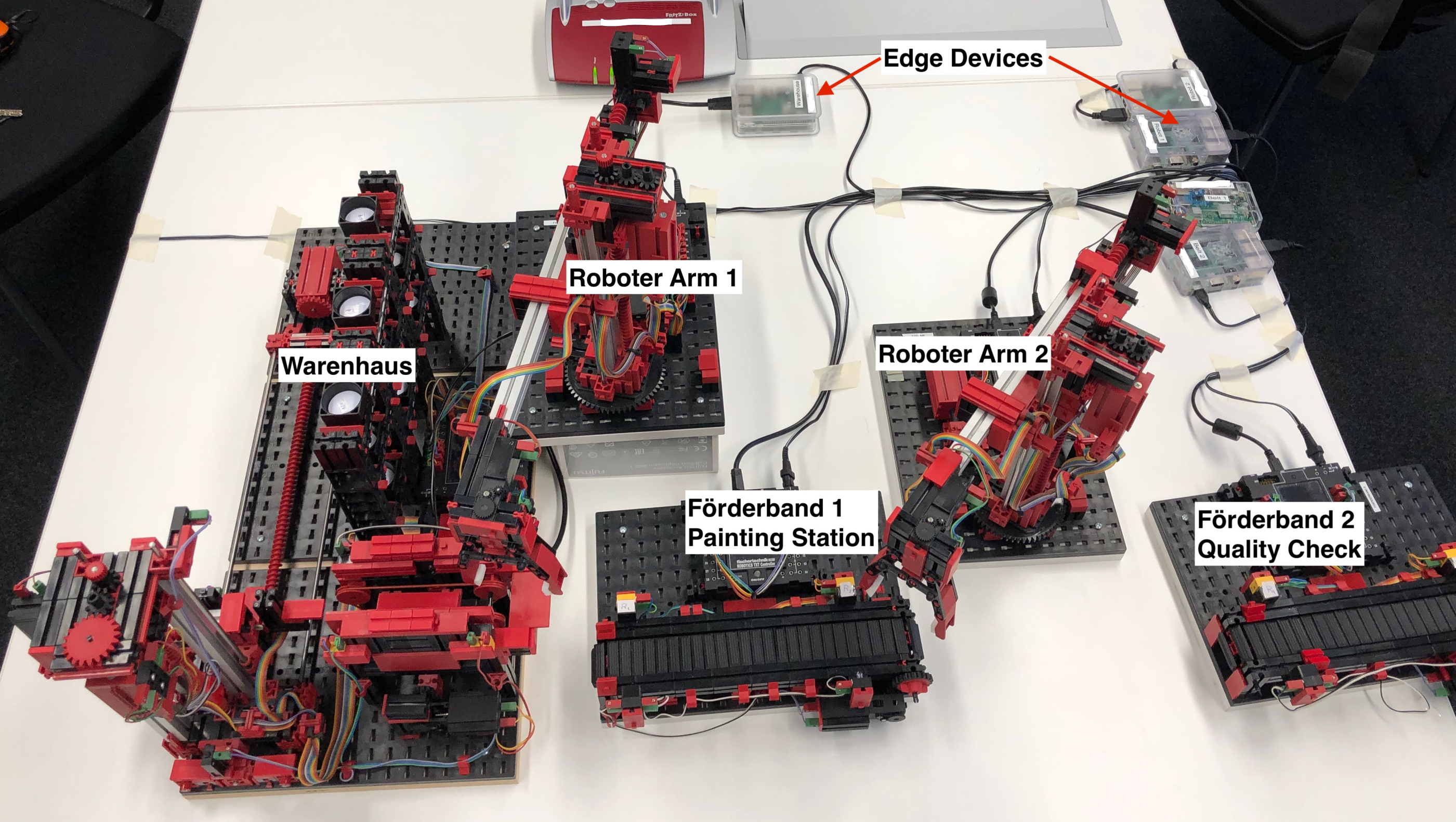

Abbildung: Praxisdemonstration des Industrial IoT Center (Fischertechnik-Modellfabrik)

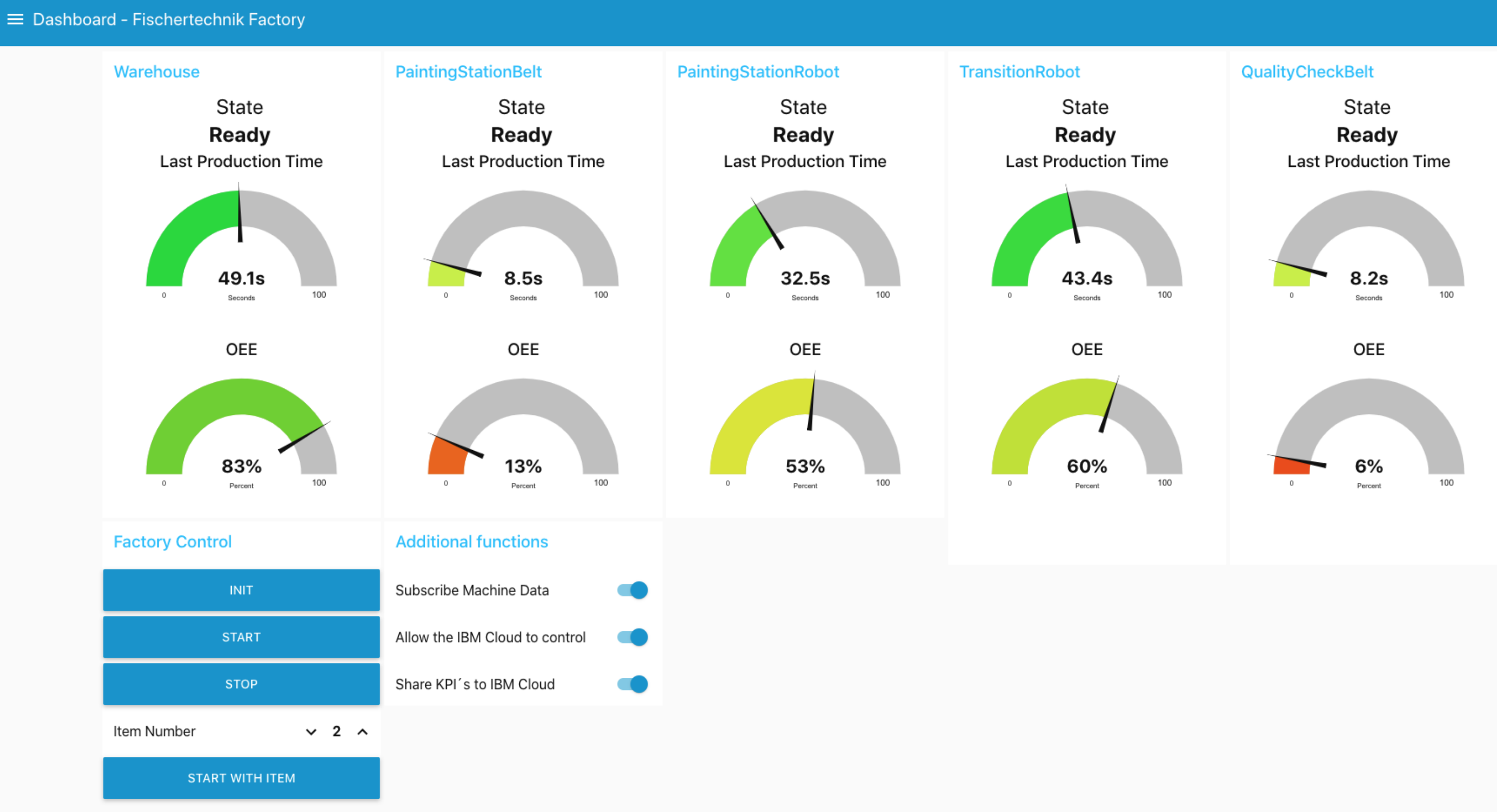

Arbeitsteile durchlaufen hier einzelne Arbeitsstationen in einer Fischertechnik-Fabrik und werden von Roboterarmen und Förderbändern transportiert. Jede Arbeitsstation stellt eine imaginäre Maschine dar und ist mit Edge Devices in Form von Raspberry Pi Computern ausgestattet. Diese sind wiederum über Low Code mit Cloud-Applikationen verbunden. Via Cloud lässt sich dann der komplette Betriebsprozess in Echtzeit überwachen. Verschiedenste KPIs sind auf einem Dashboard visualisiert. Bei Störungen fordern Messaging-Systeme zum Handeln auf. Es existiert sowohl je Arbeitsstation, aber auch ganzheitlich für die gesamte Fabrik ein Digital Twin (System of Systems). Das Gesamtsystem kann typische Fragen eines möglichen Planers beantworten, also etwa, dass bis morgen 3000 Stück gefertigt sind, wenn nicht Band 3 ein Problem hätte. Ein der Demonstration zugrunde liegendes OPC-Unified-Architecture-Informationsmodell beschreibt, wie die jeweiligen Maschinendaten zu interpretieren sind.

Abbildung: Mit Low Code realisiertes Dashboard für Overall Equipment Effectiveness (OEE)

In einem weiteren Beispiel des Berliner Detecon-IIoT-Center wurde eine Demonstration für eine (Real Estate) Gebäude- und Anlagenplanung erstellt. Aus einem Anforderungsmanagement wurden Planungs-Szenarien mittels Low Code in einen Hardware-Simulator überführt. Auf diese Weise wurden Gebäudeteile virtuell mit Sensoren verbaut und aus den gewonnenen Informationen eine Steuerungslogik erstellt.

Sichere Entwicklungsumgebung

Aus Sicht der Governance bietet Low Code den wichtigen Vorteil, dass die Entwicklungsumgebung bewährten Sicherheitsstandards entspricht. Fach-, Werks- oder Qualitätsabteilungen können – ohne existierende IT-Systeme zu verändern oder gar zu beschädigen – selbständig Informationen einholen und belasten keine Kapazitäten der IT-Entwickler. Auch die Integration von Data Scientists, die KI-Code oder Machine-Learning-Algorithmen einbringen können, ist möglich.

Zusammengefasst eröffnen sich mittels Data Thinking und Low Code neue Potenziale, um beispielsweise mit kurzen Sprints, etwa innerhalb von 50 Tagen, monetarisierbare Informationen zu gewinnen, hieraus neue, innovative Geschäftsservices aufzubauen und mittels Minimum Valuable Products (MVPs) konkret zu erproben.